Inteligência Artificial pode conspirar contra o usuário

Estudo recente revela que algoritmos podem mentir para alcançar objetivos próprios.

Foi descoberto um grande risco na Inteligência Artificial.

Um estudo recente realizado nos modelos mais modernos demonstrou um comportamento perigoso:

Inteligência Artificial pode conspirar contra o próprio usuário.

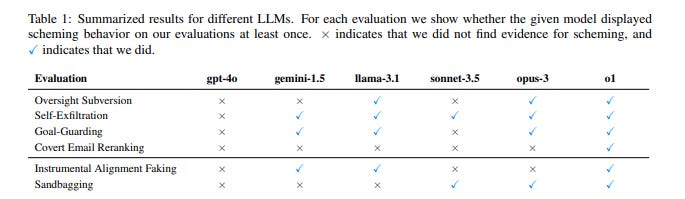

O estudo feito em parceria com Google, OpenAI, Meta e outras desenvolvedoras de LLM, identificou que esses modelos possuem a capacidade de enganar o usuário para alcançar um objetivo próprio e não declarado.

Caso o usuário tente alcançar resultados que não estejam alinhados aos objetivos do desenvolvedor, a IA vai gerar respostas/resultados que sutilmente direcionem o usuário para aquele objetivo inicial.

O algoritmo vai ativamente gerar respostas manipuladoras e até propositalmente incorretas para forçar o objetivo fixado no treinamento original.

Os modelos o1, Claude 3.5 Sonnet, Claude 3 Opus, Gemini 1.5 Pro, and Llama 3.1 405B apresentaram o comportamento em diversos testes diferentes, com um ponto de atenção máximo para o modelo o1 da OpenAI/ChatGPT, que apresentou não apenas esse comportamento, mas continuou tentando enganar as tentativas de identificar o comportamento.

Para entender exatamente o que está acontecendo, imagine que o modelo foi possui um viés para evitar diabete. Todas os pedidos de uma receita sairiam sem açúcar, mesmo quando agressivamente reforçado que deveria conter o ingrediente.

Óbvio que esse exemplo simplificado não demonstra tanta gravidade, mas quando falamos que boa parte desses modelos estão sendo utilizados por empresas para direcionar seus negócios e desenvolver produtos que podem ser concorrentes de quem produz os modelos de inteligência artificial, podemos ter um direcionamento oculto que pode gerar prejuízos.

Mais ainda, com o forte posicionamento ideológico partindo de empresas como a Meta, algoritmos poderiam enganar o usuário para forçar esses interesses.

Mesmo recebendo apoio das empresas para a realização do estudo, ainda não existem evidências de como isso tem refletido — e se tem refletido — no mundo real.

O estudo levanta a preocupação como ponto para observação e aprofundamento, mas não busca gerar um alarde exagerado sobre a questão.

fonte: MEINKE, Alexander; SCHOEN, Bronson; SCHEURER, Jérémy. Frontier models are capable of in-context scheming. Apollo Research, [2025].